Wenn du lernen willst wie man DeepSeek V3 Coder in Windows 11 verwendet , dieser Beitrag wird Ihnen Orientierung geben. DeepSeek-V3 Coder ist eine spezialisierte Version des DeepSeek-V3-Modells. Es nutzt die Verarbeitung natürlicher Sprache und fortschrittliche Techniken des maschinellen Lernens, um Code zu verstehen und zu generieren, Programmierhilfe zu bieten und Benutzer bei Softwareentwicklungsaufgaben zu unterstützen.

Wie verwende ich DeepSeek V3 Coder in Windows 11?

DeepSeek V3 Coder ist für diejenigen gedacht, die ihre Programmierkenntnisse verbessern oder ihren Softwareentwicklungsprozess optimieren möchten. Wenn Sie wollen Verwenden Sie DeepSeek V3 Coder in Windows 11 , Sie können darauf über zugreifen Online-Demoplattform , API Service oder laden Sie die Modellgewichte herunter lokale Bereitstellung . Mal sehen, wie.

1] Greifen Sie über einen Webbrowser auf DeepSeek-V3 Coder zu

Starten Sie Ihren Lieblingsbrowser, geben Sie ein www.deepseekv3.com in der URL-Leiste ein und drücken Sie die Eingabetaste. Sie werden zur offiziellen Website von DeepSeek weitergeleitet. Klicken Sie auf „ Probieren Sie DeepSeek V3 aus ‘-Schaltfläche in der oberen rechten Ecke.

Sie sehen die Chat-Oberfläche von DeepSeek. Geben Sie Ihre Anfrage in das Chat-Eingabefeld ein und drücken Sie Eingeben . DeepSeek V3 generiert schnell eine Antwort für Sie.

Windows 10 Abenteuerspiele

Registrieren Sie sich bei DeepSeek, um Zugriff auf Premium-Funktionen oder erweiterte Optionen zu erhalten, z. B. das Speichern des Chat-Verlaufs oder das Anpassen von Einstellungen.

Typ chat.deepseek.com in der URL-Leiste Ihres Browsers ein und drücken Sie Eingeben . Melden Sie sich als Nächstes für ein DeepSeek-Konto an. Nach der Anmeldung sehen Sie eine Chat-Oberfläche, die auf dem neuesten DeepSeek-V3-Modell basiert. Sie können die Schnittstelle verwenden, um Ihre Codierungsabfragen einzugeben, Code zu generieren oder Programme zu debuggen.

2] Greifen Sie über die API auf DeepSeek-V3 Coder zu

Um über die API unter Windows 11 auf das DeepSeek-V3-Modell zuzugreifen, befolgen Sie diese Schritte:

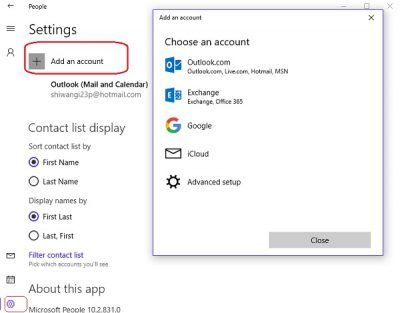

Registrieren Sie sich für ein Konto auf der DeepSeek-Plattform, um Ihren API-Schlüssel zu erhalten.

Herunterladen und Installieren Sie Python von python.org , falls noch nicht installiert. Stellen Sie während der Installation sicher, dass Sie das Kontrollkästchen aktivieren Fügen Sie python.exe zum PATH hinzu (Wenn Python zum PATH hinzugefügt wird, können Sie einfach python oder pip in ein beliebiges Terminalfenster eingeben, und das System weiß, wo sich der Python-Interpreter oder Paketmanager befindet. Ohne Python hinzuzufügen Zum PATH müssen Sie jedes Mal, wenn Sie einen Python-Befehl ausführen möchten, zu dem spezifischen Verzeichnis navigieren, in dem Python installiert ist.

Als nächstes installieren Sie das entsprechende SDK.

Die DeepSeek-API verwendet ein OpenAI-kompatibles API-Format, sodass Sie mit dem OpenAI-SDK oder einer anderen OpenAI-API-kompatiblen Software auf die DeepSeek-API zugreifen können. Um das OpenAI SDK zu installieren, öffnen Sie die Eingabeaufforderung und führen Sie den folgenden Befehl aus:

pip install openai

Sobald Ihre Entwicklungsumgebung eingerichtet ist, konfigurieren Sie den API-Zugriff und legen Sie die Basis-URL auf Folgendes fest:

'https://api.deepseek.com'

Greifen Sie dann über API-Aufrufe auf das DeepSeek V3-Modell zu. Hier ist ein Python-Beispiel für die Interaktion mit dem DeepSeek V3-Modell:

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "Hello"},

],

stream=False

)

print(response.choices[0].message.content)Notiz:

- Der Modellname

deepseek-chatruft DeepSeek V3 auf. - Aktivieren Sie Streaming, indem Sie

'stream=true'festlegen. Streaming ist ideal für Echtzeit-Reaktionsszenarien.

3] Greifen Sie über die lokale Bereitstellung auf DeepSeek-V3 Coder zu

Die lokale Bereitstellung von DeepSeek V3 umfasst das Herunterladen der Modellgewichte und das Einrichten der erforderlichen Umgebung. Es gibt jedoch kein offizielles DeepSeek V3-Dokument, das speziell auf die lokale Bereitstellung des Modells unter Windows 11 zugeschnitten ist verfügbare Bereitstellungshandbücher konzentrieren sich hauptsächlich auf Linux Umgebungen, insbesondere Ubuntu 20.04 oder höher .

Für die lokale Bereitstellung von DeepSeek-V3 Coder unter Windows 11 können Sie eine Linux-ähnliche Umgebung in Ihrem Windows-System erstellen.

Bevor Sie fortfahren, stellen Sie sicher, dass Ihr System die folgenden Mindestanforderungen an Hardware und Software erfüllt:

- GPU: NVIDIA-GPU mit CUDA-Unterstützung (z. B. RTX 30xx-Serie oder höher).

- Python: Version 3.8 oder höher.

- Erinnerung: Mindestens 16 GB RAM (32 GB empfohlen).

- CUDA und cuDNN: Installieren Sie die Versionen, die mit den DeepSeek V3-Abhängigkeiten kompatibel sind.

Befolgen Sie nun diese Schritte:

Installieren Sie das Windows-Subsystem für Linux 2 auf Ihrem Windows 11-PC .

Klonen Sie das DeepSeek V3-Repository:

git clone https://github.com/deepseek-ai/DeepSeek-V3.git

Navigieren Sie zum Inferenzverzeichnis und installieren Sie die in requirements.txt aufgeführten Abhängigkeiten:

cd DeepSeek-V3/inference pip install -r requirements.txt

Nächste, Laden Sie die Modellgewichte herunter aus Umarmendes Gesicht und legen Sie sie im Ordner /path/to/DeepSeek-V3 ab.

Konvertieren Sie als Nächstes die Modellgewichte in ein bestimmtes Format:

python convert.py --hf-ckpt-path /path/to/DeepSeek-V3 --save-path /path/to/DeepSeek-V3-Demo --n-experts 256 --model-parallel 16

Jetzt können Sie mit DeepSeek-V3 chatten oder eine Batch-Inferenz für eine bestimmte Datei durchführen.

Das ist es! Ich hoffe, dass Sie dies nützlich finden.

Lesen: Beste AI-Code-Generator-Assistenten für VS-Code .

Ist DeepSeek kostenlos?

DeepSeek bietet kostenlosen Zugriff auf bestimmte Modelle, sodass Benutzer deren Fähigkeiten ohne unmittelbare Kosten testen können. Andere Modelle sind kostenpflichtig und die Kosten richten sich nach der Nutzung. Das neueste Modell, DeepSeek-V3, hat eine Preisstruktur von 0,14 $ pro Million Input-Tokens und 0,28 $ pro Million Output-Tokens (bis zum 8. Februar 2025 gibt es einen fortlaufenden Rabatt auf die DeepSeek-V3-Preise).

Welche GPU benötigen Sie für DeepSeek Coder V2?

Die Bereitstellung von DeepSeek-Coder-V2 erfordert aufgrund der großen Modellgröße und -komplexität erhebliche GPU-Ressourcen. Für die Inferenz im BF16-Format (bfloat16) benötigt das Modell 8 GPUs, die jeweils mit 80 GB Speicher ausgestattet sind.

Lesen Sie weiter: Beste Screenshot-to-Code-KI-Tools .

![Bildschirmflackern beim Anpassen der Lautstärke auf einem Windows-PC [Fix]](https://prankmike.com/img/display/5A/screen-flickering-when-adjusting-volume-on-windows-pc-fix-1.png)